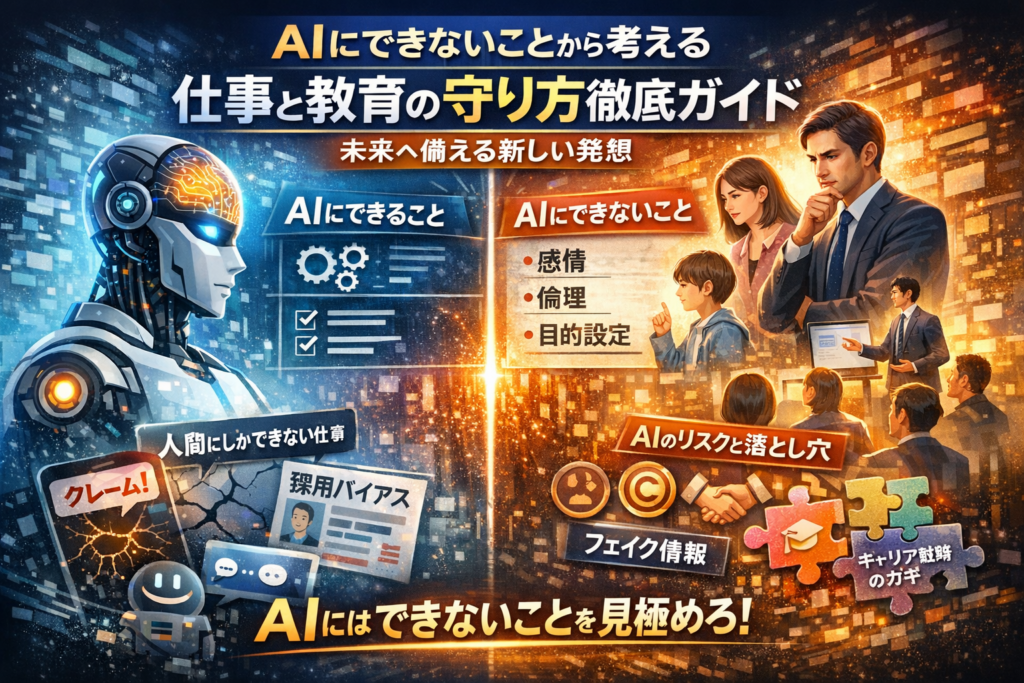

あなたの仕事や教育現場で、すでに静かに損失が積み上がっています。理由は単純で、「AIにできることとAIにできないこと」の線引きを曖昧なままにしているからです。AIに任せてはいけない判断やコミュニケーションまで手放す一方で、本来AIに任せてよい単純作業を抱え込み続けている。この構造が、時間と信用とキャリアの目減りを生んでいます。

本記事は、AIにできないこと一覧やAIが絶対に得意ではない三つの領域、生成AIの弱点とリスクを整理するだけでは終わりません。人間にしかできないことを仕事単位にまで分解し、「AIに奪われた仕事」と「AIに奪われない仕事」の具体例から、どこをAIに渡しどこを死守すべきかを明確にします。企画職やマーケ、人事など非エンジニアが、自分のキャリアをAI時代仕様に組み替えるための実務マップです。

さらに、チャットボットのクレーム増加、採用AIのバイアス再生産、教育現場での生成AIレポートなど、現場で本当に起きているつまずきから、AIにできないことの「実害」を解剖します。そのうえで、AIにできないこと教育のポイントや、AIにできないことを軸にした文系・理系別のキャリア戦略、明日から試せる役割分担の練習法まで落とし込みます。

検索では拾いきれないレベルで、「AIにできないことはあるのか」「人間にできてAIにできないことは何か」「人間がAIに勝てるものはどこか」という問いに決着をつけたいなら、この先の章を飛ばさず読み進めてください。ここを押さえないままAIを使い続けること自体が、これからの最大のリスクになります。

目次

AIにできることとAIにできないことを一覧でざっくり整理しよう

「自分の仕事、どこまで機械に任せて大丈夫なのか」。このモヤモヤをつぶすには、まず全体像を一枚で押さえることが近道です。ここでは、企画職や人事、マーケ職の方が自分の業務にそのまま当てはめられるレベルまで分解していきます。

AIのできることや苦手なことを一枚の表でイメージする

現場でよく見るのは、AIに向いていない業務まで押し込んで失敗するパターンです。そこでまず、得意領域と苦手領域を対比します。

| 領域/観点 | 得意なこと | 苦手なこと |

|---|---|---|

| 情報処理 | 大量データの集計、パターン検出、需要予測 | データが存在しない新しい事象の理解 |

| 言語 | 定型文生成、要約、翻訳 | 行間や皮肉、本音と建前の読み取り |

| 判断 | ルールベースの合否判定、スコアリング | 価値観が揺れるグレーゾーンの判断 |

| 仕事 | ルーチン作業、自動レポート作成 | 例外対応、顧客ごとの文脈調整 |

| 関係性 | FAQ回答、一次受付 | 信頼構築、謝罪、ネゴシエーション |

ポイントは、「できること」と「任せてはいけないこと」がとなり合っていることです。問い合わせ窓口で、よくある質問への回答はAIが瞬殺できますが、怒っている顧客への謝罪や火消しを任せると一気に炎上に向かいやすくなります。

私の視点で言いますと、まず自分の1日の業務をこの表のどこに当てはまるか色分けしてみると、どこをAIに委ね、どこを自分の武器として磨くかがかなりクリアになります。

人工知能や機械学習やディープラーニングが苦手な領域とは

AIの限界は「アルゴリズムが悪いから」ではなく、仕組みそのものに由来します。キーワードは次の3つです。

-

データが薄い領域に弱い

-

枠組みを自分で決められない

-

常識や空気の読み替えができない

機械学習や深層学習は、過去データから「よくあるパターン」を学ぶ仕組みです。裏を返せば、次のような場面では一気に精度が落ちます。

-

初めての商材や前例のないビジネスモデルの評価

-

コロナ禍直後のように、過去の統計が通用しない環境変化

-

社内政治や利害関係者の思惑が入り組んだ意思決定

ここで効いてくるのが、フレーム問題と呼ばれる壁です。AIは「何を問題として切り取るか」を自分では決められません。与えられた前提の中で最適解を探すことは得意ですが、「そもそも前提は妥当か」「この指標で評価すると誰が損をするか」といった視点は持てません。

実務では、AI導入プロジェクトでよく次のようなすれ違いが起きます。

-

経営層: 「採用を公平にしたいからAIでスクリーニングしたい」

-

現場: 「そもそも何をもって公平とするか決まっていない」

-

システム: 過去に合格した人材に近い傾向を“正解”として忠実に再現する

この瞬間、「多様性を高めたい」という経営の狙いと、「過去と同じ人を選ぶ」AIの動きが真逆になります。ここに気づけるかどうかが、AIと人の役割分担を設計するうえでの分かれ道になります。

まずは、自分の現場で「前例が少ない」「関係者の感情が強い」「前提から疑い直す必要がある」仕事をリストアップしてみてください。そこが、人が手放してはいけない領域であり、これからキャリアの核になりやすい部分です。

AIが絶対に得意ではない三つの領域で見えるAIにできないこと「感情・倫理・目的設定」

ビジネス現場でAIを導入していると、「このラインを越えた瞬間に、一気に危なくなるポイント」がはっきり見えてきます。感情、倫理、目的設定の3つです。この3領域を押さえておくと、自分の仕事がどこまで任せられて、どこからが人間の出番かが一気にクリアになります。

下の表は、AI活用プロジェクトでよく問題になる境界線を整理したものです。

| 領域 | AIが得意なこと | AIが苦手なこと |

|---|---|---|

| 感情 | 文章や音声のパターンから感情ラベルを推定 | 本音・葛藤・沈黙の意味をくみ取る |

| 倫理 | ルール通りの判定システム | グレーゾーンでの「例外OK」の判断 |

| 目的 | 与えられた指標の最大化 | そもそも何を最適化すべきかを決める |

AIの弱点その一は人の感情を本当にわかることというAIにできないこと

AIの感情分析は、あくまで「怒りっぽい文の特徴」「落ち込んだ声の特徴」といったデータパターンの認識です。そこに人生の文脈や人間関係の履歴は入りません。

現場で典型的なのが、チャットボットによるクレーム対応の炎上です。

-

顧客は「怒り」より「不安」を解消してほしい

-

しかしシステムはFAQを機械的に繰り返す

-

結果として、「ちゃんと話を聞いていない」と感じさせて火に油を注ぐ

私の視点で言いますと、問い合わせ窓口を設計するときは、次のような線引きが肝になります。

-

初歩的な質問や手続き案内はAIに任せて効率化

-

「返金」「解約」「健康・家族」に触れた瞬間は必ず人間にエスカレーション

-

チャットの途中でも、怒りや長文が続いたら自動でオペレーターに切り替え

ここを曖昧にした導入は、ほぼ例外なくクレーム増加につながります。AIは文章や音声を処理する技術として優秀でも、「この一言はあえて言わない」という空気の読み方は、人しか持っていない判断軸です。

AIの弱点その二は倫理や責任を引き受けることというAIにできないこと

医療、金融、採用のように人生に直結する分野では、AIの判断がどれだけ高度でも、「最後のOKボタン」は人間が押す必要があります。理由は単純で、責任を負えるのは人だけだからです。

採用システムを例にすると、AIは過去の合格者データを学習して「自社が好む傾向」を驚くほど正確に再現しますが、そこには次のようなリスクがあります。

-

過去に偏りのある採用をしていた場合、そのバイアスをそっくり再生産する

-

一見「公平なアルゴリズム」に見えても、出てくる結果はむしろ不公平

-

「なぜ落としたのか」を説明できないブラックボックスになりやすい

倫理面を担保するには、AIのスコアを鵜呑みにせず、

-

年齢や性別など、使ってはいけない情報が紛れ込んでいないか

-

特定の属性だけ不自然に不利になっていないか

-

拒否した候補者に対して、人として説明可能な理由があるか

を、人間側で継続的にチェックする体制が欠かせません。倫理と責任を引き受ける役割は、今後も人材やマネジメントの中心的な仕事として残り続けます。

AIの弱点その三は目的を自分で決めることというAIにできないこと

AIは「売上を最大化せよ」「離職率を下げよ」といった、与えられた目的には驚くほど忠実です。しかし、「売上と従業員の健康、どちらを優先すべきか」といった価値の衝突には、自分から問題提起できません。

経営や教育の現場では、この目的設定のまずさがそのままトラブルに直結します。

-

コールセンターで「1件あたりの対応時間の短縮」だけを最適化

-

AIが短時間での切り上げを促すスクリプトを量産

-

結果として、顧客満足度が落ち、解約率と炎上コストが増加

これは、指示した指標が間違っていた典型例です。AIのアルゴリズムやシステムではなく、「何をゴールに据えるか」を決めた人間側の設計が失敗しています。

目的設定を誤らないために、現場では次のようなチェックが有効です。

-

その指標だけ良くなっても、本当にビジネスとしてうれしいか

-

顧客、従業員、社会への影響をセットで評価しているか

-

例外処理にどれくらい人の判断を残すかを最初に決めているか

このフレームを設計する力は、AIには委ねられません。企画職やマーケ、人事のように「何を問題とみなすか」「どんな未来を良しとするか」を定義する仕事ほど、むしろ価値が高まっていきます。

人間にしかできないことは何か「仕事」で考えるAIにできないことリアルリスト

AIに奪われにくい仕事の共通点に潜むAIにできないこととは

仕事が機械に置き換わるかどうかは、「作業内容」よりも「判断の質」で決まります。私の視点で言いますと、次の3つが濃く含まれる仕事ほど、置き換わりにくいです。

-

相手の本音や感情を読み取って打ち手を変える

-

正解が1つではない中で、価値観にもとづき決める

-

想定外の出来事を、周囲を巻き込みながら軌道修正する

逆に、入力が決まっていて、判断基準もマニュアルで書ききれる業務は、かなりの速度で自動化されます。

ここで、日々の業務を次のように整理してみてください。

| 観点 | 機械に向く作業 | 人に残りやすい仕事 |

|---|---|---|

| 判断基準 | 数値や規定で決まる | 文脈や価値観で揺れる |

| 相手 | 画面越しのデータ | 目の前の生身の人 |

| 変化 | パターンが安定している | 想定外が頻発する |

| 成果物 | レポートや帳票 | 信頼関係や納得感 |

自分の1日のスケジュールをこの表で塗り分けてみると、「どこを任せて、どこを伸ばすか」が一気に見えてきます。

AIに取られない仕事の代表例と日常シーンから見えるAIにできないこと

置き換えられにくい職種は、派手な専門職よりも、むしろ泥くさい現場に多いです。

-

看護・介護・保育

深夜のナースコールで、患者の声色だけで「本当は不安で眠れない」と察して、5分だけベッドサイドに座る。この5分は、どれだけデータを学習しても再現が難しい領域です。

-

営業・コンサル・人事

提案そのものより、「このタイミングであえて売り込まない」判断が信頼を生みます。情報分析はシステムに任せても、「今は踏み込まない」というブレーキは人の役割です。

-

クリエイティブ職

生成モデルは画像や文章を大量に作成できますが、「そのブランドが長年積み上げてきた空気感」を踏まえた一行キャッチコピーは、人と対話をしながらでないと生まれにくいです。

日常シーンでいえば、次の瞬間に価値が生まれています。

-

相手の表情が曇った一瞬を見逃さず、話題を変える

-

会議の空気が重くなったときに、あえて冗談でほぐす

-

チームの疲れを感じ取り、期限より休息を優先する

ここには、感情の微妙な揺れと、倫理観や組織文化への理解が重なっており、単なる情報処理では届きません。

すでにAIに奪われた仕事と今も人間にしかできないことに関係するAIにできないこと

すでに置き換えが進んでいる業務も、冷静に分解すると「奪われた部分」と「人に残る部分」がはっきり分かれます。

| 業務領域 | 置き換えが進んだ作業 | 今も人に残る役割 |

|---|---|---|

| 事務・バックオフィス | データ入力、定型レポート作成 | ルール設計、例外処理、部門調整 |

| カスタマーサポート | FAQ回答、ステータス案内 | 怒りや不安への共感対応、謝罪 |

| 採用・人材 | 書類スクリーニング | 最終面接、組織との相性判断 |

問い合わせチャットボットの現場では、「よくある質問」には高速で対応できる一方で、怒っている顧客に対して定型文を繰り返し、火に油を注いでしまうケースが後を絶ちません。ここで求められるのは、言葉そのものよりも「相手は今、何に傷ついているのか」を読む力です。

採用システムでも、過去データだけで合否を決めると、組織が無意識に選んできた偏りをそのまま増幅させます。最終的に「この人と一緒に働きたいか」を引き受けるのは、価値観を言語化できる人事や現場マネージャーです。

一見地味ですが、ルールづくり、例外への腹落ちのいく説明、関係者の納得形成といった仕事は、どの業界でも最後まで残ります。ここを自分の武器として鍛えておくことが、これからのキャリア防衛どころか、キャリア加速のポイントになります。

キャリアの武器をどう選ぶかAIにできないことを軸にした戦略

AI時代のキャリアは、「何が得意か」ではなく「どこでAIと組むか」を押さえた人から一気に抜けていきます。ここでは、仕事を細かく分解し、人間側の強みを戦略的に積み増す視点を整理します。

人間がAIに勝てるものをスキルとして分解しAIにできないことを活かすには

AIはデータとパターン処理に強い一方、文脈や価値観が絡む判断は苦手です。業務を分解すると、人が磨くべきスキルがはっきりします。

| 業務の要素 | AIが得意な領域 | 人間側の武器になる領域 |

|---|---|---|

| 情報収集・整理 | 大量データの検索と要約 | 取捨選択のセンスと優先順位付け |

| 企画・意思決定 | 過去データからの予測分析 | 前例のない打ち手とリスクの覚悟 |

| 顧客・メンバー対応 | 定型チャットボット対応 | 感情の読み取りと関係性の構築 |

| 組織・ルールづくり | シミュレーション | 公平性や倫理を踏まえた判断 |

私の視点で言いますと、「判断」「関係性」「設計」の3つをスキルとして言語化しておく人は、AI導入が進むほど社内で手放せない存在になっています。

強みにしたいスキルは次のように鍛えます。

-

共感力: 1対1の対話で「相手が本当に気にしている一言」をメモして次回必ず触れる

-

ファシリテーション: 会議のゴールと決定ルールを毎回ホワイトボードに可視化する

-

倫理観と判断軸: 自分なりの「やらないライン」を文章にして定期的に見直す

これらはAIが学習データから再現しにくい、人間側のコア資産になります。

AIに取られない仕事を文系や理系で考えるAIにできないこと視点

「文系だから不利」「理系だから安泰」といったざっくり区分では、戦略を誤ります。大事なのは得意分野にAIをどう組み込むかです。

| タイプ | 強み | AIに任せる部分 | 自分が伸ばす部分 |

|---|---|---|---|

| 文系 | 言葉、物語、関係性 | 文章のたたき台生成、情報整理 | 取材力、インタビュー、編集判断 |

| 理系 | 数字、構造化、システム設計 | 分析の自動化、コード生成 | 要件定義、リスク評価、説明力 |

文系はコンテンツやストーリーづくりで生成AIを下書きとして活用し、「誰に届けるか」「どの表現なら刺さるか」の最終判断を自分の武器にします。

理系やエンジニアは、プログラミングや分析の自動生成に頼りつつ、「何を作るべきか」「ビジネスにどうつなげるか」の設計力を磨くと価値が跳ね上がります。

学校教育でも、この視点を織り込み、「AIを使いこなす文系」「人を動かせる理系」という育て方が進み始めています。

明日からできるAIと人間の役割分担をAIにできないことで実現する練習法

抽象論だけでは行動は変わりません。ビジネスの現場で明日から試せるシンプルな練習を3つ挙げます。

-

業務を30分で棚卸しする

- 自分の1日の作業を箇条書きにする

- 各項目に「AIに任せたい」「人間がやるべき」の印を付ける

- 任せたい部分は具体的にどのサービスやシステムで代替できるかを書き出す

-

あえてAIが苦手そうな相談を投げてみる

- 生成AIに、評価面談のフィードバック文やクレーム返信案を作らせる

- 「この一文は絶対そのまま送れない」と感じたポイントをメモする

ここに、感情や倫理に関わる判断が集中しており、自分が磨くべき領域が見えてきます。

-

チームでチャットボットの限界をシミュレーションする

- 想定問答をAIに作らせる

- わざと怒っている顧客や迷っている顧客のシナリオを用意し、人間同士で最適な対応をディスカッションする

この練習を続けると、「どこまでをAIに任せ、どこからを自分が引き受けるか」の線引きが、感覚ではなくスキルとして身についていきます。キャリアの武器は、華やかな資格よりも、この線引きを説明できる力にシフトしつつあると言ってよい状態です。

生成AIにできないことと注意したいリスクや幻覚・バイアス・著作権問題

生成AIは「一瞬でそれらしい文章や画像を出す魔法のツール」に見えますが、現場を見ていると、うまく使えたチームと炎上したチームがはっきり分かれます。鍵になっているのが、ここで扱う3つの弱点です。

生成AIが苦手なことは事実確認やオリジナルな意図読みというAIにできないこと

生成AIは大量のテキストや画像データから「それっぽい回答」を作るシステムです。裏側では検索エンジンのような情報取得ではなく、「こう続きそう」という確率で文章を生成しています。そのため、事実確認と意図読みには決定的な限界があります。

私の視点で言いますと、ビジネス現場で特に危ないのは次の3パターンです。

-

法律や医療、金融商品などYMYL領域の質問に断定調で答えてしまう

-

存在しない論文や統計データを自信満々に提示する

-

上司や顧客の「本音」を推測したかのようにストーリーを作る

人間と生成AIの違いを簡単に整理すると、次のようになります。

| 項目 | 人間 | 生成AI |

|---|---|---|

| 事実確認 | 資料や一次情報を突き合わせて検証する | もっともらしいパターンを作るだけで裏取りはしない |

| 相手の意図読み | 目線や沈黙、過去の関係性まで踏まえて解釈する | 入力文だけから推測し、文脈を狭く取りがち |

| 間違いに気づく力 | 違和感や責任感から「本当に大丈夫か」を疑う | 自分の誤りを自律的に検証できない |

レポート作成や企画書のたたき台に活用するのは有効ですが、「最終チェックは必ず人間」が原則になります。

バイアスやプライバシーそして著作権の落とし穴に関連したAIにできないこと

生成AIは学習データに含まれる偏りを、そのままコンテンツに反映します。採用や評価のシステムに直結させると、過去の人事データにあったバイアスを再生産しやすくなります。

具体的に起きがちなリスクは次の通りです。

-

性別や年齢、学歴に偏った「理想像」を推薦してしまう

-

社内チャットを学習させ、機密情報を外部サービスに渡してしまう

-

既存の画像・文章に酷似したアウトプットを出し、著作権トラブルを招く

この領域でAIに任せられないポイントは、「どこまでを学習に使ってよいか」「どのルールが不公平か」を人間が判断することです。プライバシーポリシーや契約書の設計、研修によるリテラシー教育は、依然として人間側の仕事として残ります。

教育現場での生成AI利用とここは人間の出番となるAIにできないこと線引き

学校や研修の現場では、生成AIを完全禁止するか、フル解禁するかで揉めやすいですが、本質は「どこで使わせ、どこで使わせないか」の設計にあります。

教育の現場で頻出するケースを整理すると次のようになります。

| シーン | 生成AIに任せてよい部分 | 人間の出番が必須な部分 |

|---|---|---|

| レポート作成 | 構成案や問いの例、参考文献の候補出し | 何を主張したいかを決める、根拠を自分で探す |

| 課題の下調べ | 用語の意味や歴史的な流れの整理 | 情報の信頼性チェック、複数資料の比較 |

| グループワーク | アイデアのブレスト補助 | 意見の対立をどう調整するか、結論をどう社会に接続するか |

教育現場でよくある「AI丸投げレポート」は、文章に独特の平板さが出ます。具体的な体験談が薄く、指示語が多く、文体が妙に整い過ぎるのが典型的です。教員側は、この違和感を見抜くだけでなく、「どの工程を自分の頭でやるべきか」を学生と共有することが重要になります。

ビジネスパーソンも同じで、調査やドラフト作成をAIに任せつつ、「目的設定」「優先順位づけ」「リスク判断」を自分でやる習慣をつけるほど、キャリアの安全地帯は広がっていきます。

教育やコミュニケーションで浮き彫りになるAIにできないこと教育の核心

「子どもに何を教えれば、AI時代でも食いっぱぐれないのか」ここが親や教員、マネジャーの本音だと思います。鍵になるのが、教科書にはほとんど載っていない“対話の質”と“考え方の設計力”です。

AIにできないことを子どもや学生にどう教えるかを考える

学校や研修に生成型のツールを導入すると、レポートや企画書は一気にきれいになります。一方で、現場の教員が口をそろえて言うのは「文章は整っているのに、その人らしさが消えている」という違和感です。

典型的なレポートの違いを整理すると次のようになります。

| 項目 | 生成ツール主体のレポート | 学習者が自分で考えたレポート |

|---|---|---|

| 構成 | 無難で整っている | 多少いびつでも筋が通っている |

| 言葉づかい | 一般論が多く、誰が書いても同じ | 体験や感情の温度がにじむ |

| 誤り | 事実関係が曖昧なことがある | 情報は少なくても自分の目線が明確 |

私の視点で言いますと、ここを指導で活かすには「結果」ではなく「プロセス」を評価軸に入れることが欠かせません。

例えば授業や研修では、次のステップで使い分けを教えると効果的です。

-

まず自分の言葉で仮の答案や企画案を書く

-

その後にAIで情報と例を追加し、足りない視点を補う

-

最後に「どこを採用し、どこを捨てたか」を口頭で説明させる

この3ステップにすると、単なる作業の効率アップではなく、「判断」「編集」「取捨選択」といった人間側の学習が強化されます。教員は答案そのものより、説明時の迷い方や言い換え方を観察することで、その人がどこまで理解しているかをつかめます。ここはデータや画像では読み取りにくい領域です。

コミュニケーションの現場で明らかになるAIにできないことと思考の違い

ビジネス現場でも学校でも、チャットボットへの相談は増えています。FAQや基本情報の案内には非常に向いていますが、人が本当に困っている時ほど、ロボット的な回答が火に油を注ぐケースが目立ちます。

感情が絡む場面での違いを整理すると、次のようなギャップが見えてきます。

| シーン | AIの反応 | 人間の反応 |

|---|---|---|

| 部下がミス報告 | 手順と対処方法を提示 | まず「大丈夫?」と感情を受け止める |

| 保護者クレーム | 事実と規定を丁寧に説明 | 相手の背景を探り、落とし所を一緒に探す |

| 生徒の進路相談 | 適性データから候補を列挙 | ためらいや表情から本音を引き出す |

AIは情報やデータを基に最適解を提示するシステムです。一方、人は「沈黙の長さ」「目線」「声の揺れ」といった、文字にならない信号を総合して判断します。ここから生まれるのが、あえて何も言わない決断や、あえてルールを柔らかく解釈する一手です。

現場でトラブルが増えるのは、チャットボットの窓口を厚くして、人が出てくるラインを細くし過ぎたケースです。問い合わせ対応を設計する時は、次のようなルールを置くとクレームが激減します。

-

「怒り」や「不安」を示す言葉が一定回数出たら必ず人につなぐ

-

高校や大学、企業では、進路や評価に関する相談は最初から人が一次対応する

-

AIの回答履歴を人間が定期的にレビューし、誤解を生みやすい表現を更新する

このように、教育とコミュニケーションの場では、AIが得意な情報処理をフル活用しつつ、「空気を読む」「意図を察して枠を変える」といった、人だけが担える仕事をどこに残すかが勝負どころになります。その線引きを言語化して子どもやメンバーと共有しておくことが、AI時代のリテラシー教育の中核になっていきます。

現場で実際に起きたAI導入のつまずきとそこから見えるAIにできないこと

「入れた瞬間”神ツール”、半年後には”現場の敵”」

AI導入の失敗パターンは、ほぼすべてがこの一言に集約されます。華やかなPoCの裏側で、クレーム増加や人件費増大が静かに進行しているケースを、現場視点で分解してみます。

よくあるトラブル事例で発覚するAIにできないことチャットボットのクレーム増加ケース

問い合わせチャットボットは、導入初期だけ満足度が高く、その後クレームが増えるパターンが頻発します。私の視点で言いますと、原因は「感情」と「例外」に対する設計不足です。

| 項目 | 導入前の想定 | 実際に起きたこと | 根本原因 |

|---|---|---|---|

| FAQ対応 | よくある質問は自動で解決 | 怒っている顧客ほど離脱・炎上 | 文面から感情レベルを読み取れない |

| 切り分け | 複雑な相談は人へ転送 | 転送までに何度も同じ説明をさせてしまう | 会話の「文脈」を保持しきれない |

| 効率 | オペレーター削減 | 結局ベテランが後処理で疲弊 | 例外パターンをナメていた |

ポイントは、AIが文章の意味は理解しても「この人は今どれくらい怒っているか」「ここで一言謝るべきか」といった温度感を扱えないことです。ビジネス現場では次のような構造が起きます。

-

強めの言葉遣いを「通常の問い合わせ」と判断し、定型文で返す

-

顧客は「話が通じない」と感じ、同じ内容をコールセンターで再説明

-

オペレーターはチャット履歴を読み解く時間が増え、処理件数が減る

設計段階で必須なのは、感情レベルのスコアリングと早期の人へのバトンタッチです。例えば「怒り語彙が一定数を超えたら即人間へ」「3ターン同じ意図の質問が続いたら人へ」といったルールを、業務システム側に組み込む必要があります。

採用AIがバイアスを再生産してしまうというAIにできないことの仕組み

採用支援のシステムでも、「公平な判断」を狙ったはずが、逆に偏りを強めてしまう事例が出ています。ここで露呈する弱点は、目的とルールを自分で疑えないことです。

| フロー | AIがしていること | 見落としがちなリスク |

|---|---|---|

| 学習 | 過去の合格者データを学習 | そもそも過去の合格者が偏っている |

| スクリーニング | 「合格者っぽさ」をスコア化 | マイノリティ属性を自動的に不利にする |

| 現場運用 | スコア順に人が確認 | スコアを疑う文化がないと盲信が起きる |

AIは「過去この会社が良いとした人材の傾向」を忠実に再現します。つまり、女性管理職が少ない組織なら、同じ傾向を未来にも延長してしまいます。

バイアスを抑えるには、技術より運用ルールとモニタリングが決定打になります。

-

性別や年齢を隠したデータでの評価結果を、属性ごとに再集計する

-

AIのスコアと人間の最終判断の差を定期的に分析する

-

「AIがはじいた候補をサンプル抽出して再評価する」プロセスを設ける

この「二重チェック」をサボると、表向きはデータドリブンでも、実態は過去の偏見を強化するだけのシステムになります。

「AIで自動化すれば人件費が下がる」は半分だけ正しいAIにできないこと設計の盲点

自動化プロジェクトで最も誤解されているのが、人件費の計算方法です。多くの企画書は「1件あたり処理時間×件数」で削減効果を出しますが、そこで無視されがちなのが例外処理とメンテナンスです。

| コスト項目 | 企画書でよく抜け落ちるポイント |

|---|---|

| 例外処理工数 | AIが判断できないパターンを人が処理する時間 |

| シナリオ改修 | 業務ルール変更時のシナリオ更新・テスト |

| データ整備 | 学習用データのクレンジングとラベリング |

| 社内調整 | 現場ルール変更の合意形成と教育コスト |

AIは、「定義された枠の中での最適化」は驚くほど速く正確にこなします。一方で、ビジネス現場で頻発する次のような事態は苦手です。

-

法改正や社内規程変更で、判断ルールが毎年変わる

-

取引先ごとの「暗黙の了解」が多くマニュアル化しきれない

-

一部のベテランだけが知るイレギュラー対応が多い

ここを見誤ると、「自動化したのに結局ベテランが後ろで全部チェックしている」という二重投資になります。自動化を成功させる現実的な順番は次の通りです。

- まず業務プロセスを標準化し、「例外」を棚卸しする

- 頻度の高いパターンだけをAIに任せ、レアケースは最初から人が担当する設計にする

- 精度だけでなく「例外率」と「手戻り件数」をKPIに入れる

この設計さえ押さえれば、AIは人を減らすツールではなく、「人が本当にやるべき判断に集中するためのフィルター」として機能し始めます。ビジネスパーソンが意識すべきは、導入そのものではなく、どこまでを任せて、どこからを人間の責任範囲にするかというラインの引き方です。

まとめとしてAIにできないことを知ったうえでどう付き合っていくか

AIにしかできないことと人間にしかできないことを掛け合わせてキャリア設計へ

仕事がAIに奪われるかどうかは、「どの作業を任せ、どの役割を手放さないか」を設計できるかで決まります。ここを曖昧にしたまま導入すると、チャットボット炎上や採用AIのバイアス再生産のようなトラブルが起こります。

ざっくり整理すると、役割分担は次のようなイメージになります。

| 領域 | AIが強いところ | 人間が担うべきところ |

|---|---|---|

| 情報処理 | 大量データの分析、パターン検出、文章生成 | 事実確認の最終チェック、根拠の評価 |

| 判断 | ルールベースの審査、スコアリング | 価値観が絡む決定、責任の引き受け |

| コミュニケーション | 定型回答、24時間対応チャット | 感情に寄り添う対話、葛藤の調整 |

| 仕事設計 | 作業の最適化 | そもそもの目的設定、例外ルール作り |

私の視点で言いますと、キャリア戦略として本当に効いてくるのは、「AIに任せると危険なグレーゾーン」を見抜ける人になることです。採用スクリーニングでスコアだけ見て決めない、人事評価でAIの提案を鵜呑みにしない、顧客対応で怒りの温度を見て人に切り替える、といった判断こそが市場価値になります。

ポイントは次の3つです。

-

AIが得意な処理は遠慮なく任せて、時間をひねり出す

-

目的設定、倫理判断、感情のケアは自分の“守備範囲”と決めて鍛える

-

自分の業務フローを、AI前提で組み替える「設計者」側に回る

この3点を意識すると、単なる「AIに負けない人材」ではなく、AIを味方につける側に立てます。

読者が明日から実行できる三つの行動でAIにできないことを活かそう

机上の理解で終わらせないために、明日からすぐ試せるアクションを3つに絞ります。

- 自分の仕事を30分で棚卸しする

-

いつもの業務を箇条書きにする

-

「ルールがはっきりしている作業」「お客様や同僚の感情が絡む作業」に分ける

-

前者はAI候補、後者は自分の武器候補としてマークする

これをやっておくと、RPAやチャットボット、分析システムの提案が来たときに、どこまで任せてよいか瞬時に判断しやすくなります。

- あえてAIが苦手そうな質問をぶつけてみる

生成サービスに、次のようなタイプの問いを投げてみてください。

-

正解が一つに決まらない倫理的な悩み

-

チームメンバー同士の感情がこじれた相談

-

自社や自分のキャリアに強く依存する戦略の相談

出てきた回答を読みながら、「どこまで参考になるか」「どこからは自分で決めるべきか」を赤ペンで書き込むと、AIとの距離感が一気につかめます。

- チームやクラスで“AIではなく人がやる理由”を話し合う時間をつくる

-

チャットボットでクレームが増えたケース

-

採用AIが特定属性ばかり通してしまうケース

-

生成されたレポートが一見きれいなのに中身が薄いケース

こうした事例を題材に、「どこで人が介入していれば防げたか」「どんなルールやチェック項目が必要か」を議論すると、教育やマネジメントの現場で使える実践知がたまります。学校なら授業の一コマ、企業なら研修や1on1で十分扱えるテーマです。

AIは、情報処理と効率化では圧倒的なパートナーになります。一方で、目的を決めて責任を取り、誰かの気持ちに向き合う役割は、人にしか渡されていません。この人間側の役割を意識して磨いていくことが、不安をチャンスに変えるいちばん現実的な近道になります。

この記事を書いた理由

著者 – 宇井 和朗(株式会社アシスト 代表)

ここ数年、支援先の企業で「AIを入れたのに、現場のストレスが増えた」という相談が急増しました。ある多店舗小売では、コールセンターをチャットボットに切り替えた直後、1か月でクレーム件数が約1.6倍になりました。問い合わせの背景にある不安や怒りをくみ取れず、定型回答を連発した結果、お客様との信頼が一気に揺らいだのです。

一方、人事部門で採用AIを導入した企業では、半年ほどで候補者の属性が極端に偏り、優秀な人材をみすみす逃していたことが後から判明しました。アルゴリズムそのものより、「何をAIに任せてはいけないのか」を決めていなかったことが最大の問題でした。

私自身も、社内の評価面談シート作成をAIに丸投げし、数字だけは整っているのに、部下が何を大事にして働いているのかが伝わらない資料になってしまい、面談後にモチベーションを下げてしまった苦い経験があります。

これらの失敗に共通していたのは、「AIにできること」と「AIにできないこと」の線引きを曖昧にしたまま、効率だけを追いかけてしまったことです。本記事では、その線引きを仕事と教育の現場レベルまで具体的に落とし込み、あなた自身の時間と信用、そしてキャリアを守る判断軸を提供したいと考えています。