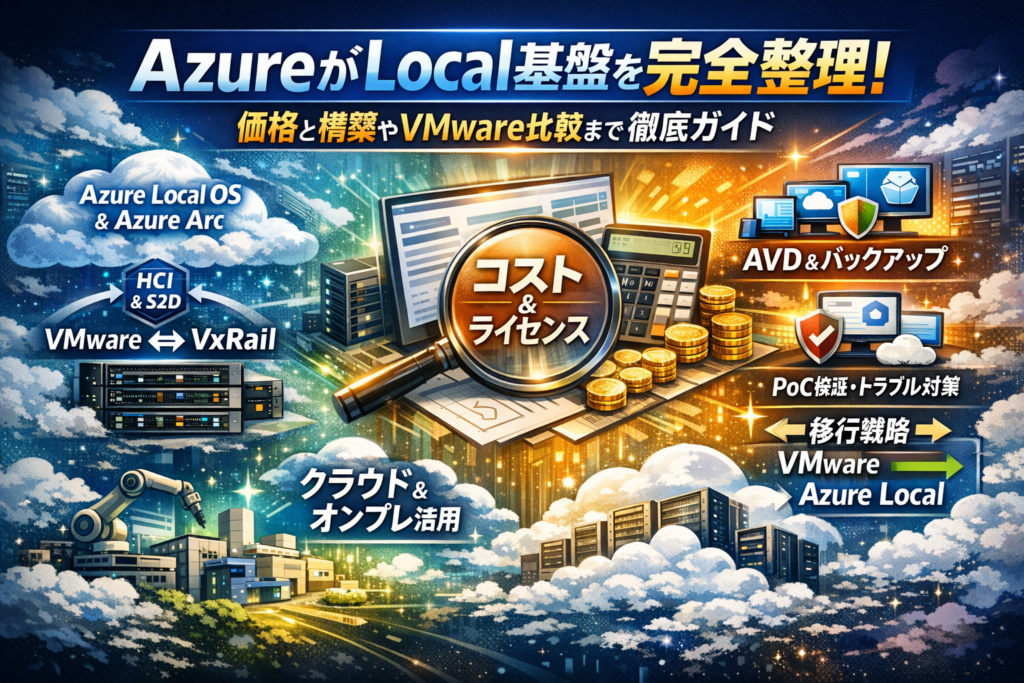

Azure Localを「名前が変わったAzure Stack HCIの後継」とだけ捉えていると、VMwareやVxRail更新の判断を誤り、数年単位で運用コストと障害リスクを抱え続けることになります。本記事は、Azure Localとは何かを5分で整理しつつ、Azure Local OSとAzure Arc、S2Dやnetwork gatewayを含むHCIアーキテクチャ、AVDやバックアップを載せた具体構成まで一気に俯瞰できるよう設計しています。

Azure Localの価格とライセンス、物理コア課金の考え方、DellやHPE、Lenovoなどのハードウェア要件とカタログの読み解き方、23H2アップグレードやdisjoint namespace、DNS設計で実際に起きたトラブルと回避策まで踏み込みます。さらに、VMwareやVxRailとの比較軸、Azure ローカル基盤でどのワークロードを動かすべきか、PoCの検証ポイント、SIerやMSPが問い合わせを生むコンテンツ設計までを一本に集約しました。この記事を読み切れば、Azure Local導入を「勘とベンダー任せ」で進めるリスクをゼロに近づけ、社内提案と実装の双方で迷いなく判断できる状態をつくれます。

目次

Azure Localとは何者かを5分で掴む|Azure Stack HCIとの違いとAzureローカル基盤の正体

クラウドもオンプレも分かっているつもりなのに、Azure Localだけ霧が晴れない。現場でよく聞く声です。実態を一言でまとめるなら、「Azureをオンプレに着陸させるためのローカルクラウドOS」だと捉えると腹落ちしやすくなります。

まず全体像をざっくり整理します。

| 観点 | 従来オンプレ仮想基盤 | Azure Stack HCI | Azure Local |

|---|---|---|---|

| 中心技術 | VMwareやHyper-V | WindowsベースHCI | 専用ローカルOS |

| 管理ポータル | vCenterなど | Windows Admin Center | Azure Portal連携前提 |

| 位置づけ | サーバ仮想化 | HCI基盤 | ハイブリッドクラウド基盤 |

この表の一段上に、Azure ArcやAdaptive Cloudという「Azure全体の絵」が乗っかるイメージです。

Azure LocalとAzure Stack HCIの関係を名前だけ変更で片付けない

名前が変わっただけ、と思っていると検証段階でつまずきます。実際には、ライフサイクルと役割が変わったOSの世代交代と見た方が正確です。

-

コアは引き続きHCIとStorage Spaces Direct

-

ただし、更新モデルやサポートはクラウドサービス寄り

-

Azure Arc連携やnetwork gateway前提の設計にシフト

という変化が入っています。

現場でよくある勘違いは、従来のAzure Stack HCI構築ガイドをそのまま流用して、DNSやドメイン設計を「いつものオンプレ流儀」で決めてしまうパターンです。結果として、後からAzure登録やMOC系サービスが不安定になり、disjoint namespaceや名前解決ループに悩まされます。

名前だけのリブランドではなく、「Azure側の一員になったHCI OS」として最初に腹を括ることが、設計のスタートラインになります。

Azure Local OSとAzure Arc、Adaptive Cloudで何ができるのか

このローカルOS単体では、単なるHyper-Vクラスタに毛が生えた程度にしか見えません。真価は、次の3点が同時にそろったときに出てきます。

-

Local OS

- Hyper-VとS2Dで仮想マシンとストレージを提供

- 物理コア課金で予算管理しやすいHCI基盤

-

Azure Arc

- ローカルの仮想マシンをAzureリソースとして一元管理

- ポリシー配布、タグ管理、Update管理をクラウド側から制御

-

Adaptive Cloudの考え方

- クラウドとローカルを「同じ運用モデル」に寄せるアーキテクチャ

- AVD、バックアップ、監視、ローカルAI推論を共通の管理フレームで扱う

AVDをローカルで動かしたり、Azure BackupでDRサイトへ複製したりといったユースケースは、この三位一体モデルがあって初めてスムーズに回り始めます。

オンプレだけ見ていると、ローカルOSのライセンス単価が高く見えがちですが、運用とセキュリティをAzure側に寄せることで削れる運用コストを数字に落とすと、経営層への説明がしやすくなります。

Azureローカル基盤がオンプレだけでもクラウドだけでもない理由

この基盤を理解するうえで、よく使う比喩があります。

オンプレだけの世界は「自社ビル」、クラウドだけの世界は「賃貸オフィス」。どちらも極端です。Azureローカル基盤は、自社ビルにAzure仕様の共用部を持ち込むイメージに近い存在です。

-

物理の場所とデータ主権は自社やリージョン内に確保

-

運用プロセスと管理ツールはAzureと共通化

-

必要なサービスだけクラウド側と接続して拡張

このハイブリッド性が効いてくるのは、次のような現場です。

-

店舗や工場での低遅延処理とAVDの組み合わせ

-

公共系でのデータ主権要件とローカルAI活用

-

VMwareやVxRailの更改タイミングで、クラウド連携を前提に基盤を刷新したいケース

私の視点で言いますと、従来の「仮想マシンが動く箱」として見ると、どのHCIも同じに見えてしまい、価格勝負に巻き込まれます。Azureローカル基盤は、クラウド級の運用とオンプレの制御性をどう両立させるかという課題に答えるための設計思想そのものだと捉えると、次のアーキテクチャ検討が格段にやりやすくなります。

Azure Localのアーキテクチャ徹底図解|HCIやS2Dやnetwork gatewayが支える土台

クラウドとオンプレの“いいとこ取り”を本気でやろうとすると、この基盤の作り込みを避けて通れません。名前だけ追っていると迷子になるポイントを、ここで一気に整理します。

Hyper-VとHCIとS2Dで作るAzure Localクラスタの基本構造

この基盤は、ざっくり言うと次の3層でできた「仮想化+共有ストレージ一体型の箱」です。

-

仮想化: Windows Server系技術のHyper-V

-

ストレージ: Storage Spaces Direct(S2D)

-

管理とクラスタ: HCIとしての制御プレーン

現場でイメージしやすいように整理すると次の構造になります。

| レイヤー | 役割 | 現場でのチェックポイント |

|---|---|---|

| ハードウェア | DellやHPEなどの認定サーバー | NICの本数と帯域、NVMe/SSDの混在構成 |

| 仮想化(Hyper-V) | 仮想マシン、AVDホスト実行 | NUMA境界とvCPU割り当て設計 |

| ストレージ(S2D) | ノード間での分散ストレージ | ミラー/パリティ比率と復旧時間 |

| クラスタ(HCI) | フェイルオーバー制御 | クォーラム構成と2ノード時の証人設計 |

| 管理プレーン | OS、管理ポータル、Arc連携 | 管理ネットワークの分離とRBAC |

ポイントは、ストレージ専用のSANが存在しないことです。S2Dがローカルディスクを束ねて“クラスタ共用ストレージ”をエミュレートするため、ネットワーク設計とディスク構成を甘く見ると性能と可用性が一気に崩れます。

私の視点で言いますと、PoCでよく起きるのは「VMは少ないのに、S2Dの再同期がやたら長い」という事象です。ほとんどのケースで、バックエンドのRDMA未活用や、ストレージ用と管理用を同じスイッチに詰め込んだ設計ミスが根っこにあります。

Azure Local network gatewayとオンプレネットワーク設計で起こりがちな誤算

この基盤を“クラウドに直結した箱”に変えるのがnetwork gatewayです。VPNやExpressRouteを通じてAzureと安全にトンネルを張り、Arc経由の管理やバックアップ、AVDと連携させます。

ところが、ネットワーク担当を巻き込まずに進めると、次のような誤算が頻発します。

-

ゲートウェイ用のグローバルIPを確保しておらず、構築直前でファイアウォール設計をやり直し

-

オンプレ側のアドレス設計が行き当たりばったりで、Azure側のアドレス空間と競合

-

プロキシ越え通信を前提にしておらず、管理ポータルだけが不安定になる

代表的な“ハマりパターン”を整理するとこうなります。

| よくある誤算 | 見た目の症状 | 事前に見るべき観点 |

|---|---|---|

| DNS設計不足 | 一部VMだけArc登録に失敗 | 正引き/逆引き、内部ドメイン設計 |

| アドレス競合 | VPN接続は張れるが通信不可 | Azure VNetとの重複有無 |

| 帯域不足 | バックアップ開始で他トラフィックが遅延 | バックアップ時間帯とQoS設計 |

| セグメント不足 | 管理とVMとストレージが同一セグメント | VLAN分割とルーティングポリシー |

network gatewayを“箱のオプション機能”として扱わず、WAN設計の延長線にある重要コンポーネントとしてルータ担当・セキュリティ担当を早めに巻き込むことが、プロジェクト成功の分水嶺になります。

Disconnected OperationsやSovereign Private Cloudでの運用イメージ

全拠点が常時インターネットにつながる前提は、工場ラインや公共系では成り立ちません。この基盤が評価されているのは、クラウドに最適化されながらも“切り離して運用できる”顔を持つところです。

-

Disconnected Operations

定期的にAzureと同期しつつ、リンク断中でもローカルの仮想マシンやサービスを継続運用します。

ファームウェア更新やOSパッチの適用を「オンライン専用」と勘違いしてスケジュールを組むと、メンテナンスが詰みやすいので、運用設計段階で“オフラインでも回るパッチ手順”を決めておく必要があります。 -

Sovereign Private Cloud

データ主権の制約で、顧客データを国外リージョンに出せないケースでも、管理プレーンの考え方をそろえつつローカル完結のインフラとして使えます。

ここで重要になるのは、どこまでをローカルに閉じ、どこからをクラウドに委ねるかという境界設定です。

| シナリオ | クラウド接続 | 設計の肝 |

|---|---|---|

| 店舗サーバー置き換え | 断続的 | オフライン時のキャッシュ戦略 |

| 工場ライン制御 | 最小限 | 低遅延ネットワークと冗長電源 |

| 公共・自治体基盤 | ポリシー制限付き | データ保管場所とログ保全 |

この3つのシナリオを並べて検討すると、「常時オンライン前提のクラウド」と「老朽化したオンプレ」の間に、この基盤をどこへ置くべきかがクリアになります。アーキテクチャを図だけで終わらせず、運用時の“切り離し方”まで描けて初めて、本当の意味でのハイブリッド基盤になっていきます。

Azure Localの価格とライセンスを経営層にも通じる言葉で整理する

オンプレ基盤の更新を「サーバーの買い替え」視点だけで見てしまうと、この基盤の本当の価格構造がいつまでも霧の中のままになります。ここでは、情シスやインフラ担当が経営層と同じテーブルで話せるように、「仮想化の技術用語」ではなく「投資とリターン」の言葉に翻訳して整理していきます。

私の視点で言いますと、うまく説明できる担当者は、決裁ではなく「一緒に設計してもらう」空気を作れています。

物理コア課金とAzure Stack HCI価格の関係をどう読み解くか

この基盤のライセンスは、ざっくり言うと「CPUの物理コア数に応じたサブスクリプション」です。ここで押さえるべきポイントは、以下の3つです。

-

物理コアが多いほど、ランニング費用が増える

-

Azure Stack HCI時代と考え方は近いが、機能とブランドが拡張された

-

ハイスペック1台より、バランスした複数ノードの方が総コストで得になるケースが多い

感覚をつかむために、あえてラフな比較軸だけを並べると次のようになります。

| 観点 | 旧来の仮想基盤 | このローカル基盤 |

|---|---|---|

| 課金単位 | CPUソケットやOS数 | 物理コア数ベース |

| 期間 | 買い切り中心 | 年間サブスクリプション |

| 投資イメージ | 初期費用の山 | 緩やかなランニング |

経営層に説明するときは、「CPUを増やすと“毎年のサブスク”が増えるので、今後3~5年の負荷予測を冷静に見てからコア数を決めたい」という言い方が伝わりやすいです。

Azure LocalライセンスとOEMモデルやサブスクリプションの組み合わせ方

次に、サーバーメーカーとの関係です。DellやHPE、Lenovoなどのハードウェアベンダーは、認定済みの構成と一緒にこの基盤を「セット商品」として提供してきます。このときのパターンを整理すると、検討が一気に楽になります。

| モデル | 特徴 | 向いている企業 |

|---|---|---|

| OEMバンドル | サーバーと基盤ライセンスを一括見積り | 初導入で構成に自信がない |

| 直接サブスクリプション | クラウド契約と同じ感覚で管理 | 既にAzure契約がある |

| 混在モデル | ハードはOEM、追加ノードは別契約 | 段階的に拠点を増やしたい |

ポイントは、「誰が窓口になってくれるか」を最初に決めることです。サーバー障害から基盤OS、ネットワークゲートウェイまで、問い合わせ先がバラバラになると、トラブル時に情シスの負荷が一気に跳ね上がります。

また、サブスクリプションをAzureの他サービス(AVDやBackupなど)と同じアカウントでまとめるか、別契約で管理するかも早めに決めておくと、後のコスト分析がスムーズになります。

見積もりで見落としやすいバックアップやAVDや監視の隠れコスト

見積書の1枚目に出てくるのは「サーバー本体とHCI基盤のライセンス」ですが、実際の財布から出ていくお金はそこだけではありません。現場で特に漏れやすいのが次の項目です。

-

バックアップとDR

- Azure BackupやSite Recoveryの料金

- バックアップ対象データ量の増加分

- オフサイト保管用のストレージ(Wasabiなど)との回線コスト

-

AVD(仮想デスクトップ)

- ユーザー数ベースの利用料

- プロファイル格納ストレージとIO性能確保のための追加ノード

- ネットワーク遅延を抑えるための回線増強

-

監視と運用

- 監視サービスやログ分析の課金(Log Analyticsなど)

- 24時間監視をアウトソースする場合の運用費

- アップグレード検証用の検証環境コスト

これらをまとめて経営層に説明するときは、「箱代」と「サービス代」を分けて見せると理解されやすくなります。

| コストカテゴリ | 代表的な中身 |

|---|---|

| 箱の投資 | サーバー、ストレージ、HCIライセンス |

| サービスの投資 | AVD、バックアップ、DR、監視 |

| 運用の投資 | 構築保守、アップグレード検証、トレーニング |

特にアップグレードや23H2適用のたびに検証工数が発生することを織り込んでおかないと、数年後に「こんなに運用費が膨らむとは聞いていない」という声が必ず出ます。価格の議論を始める段階から、「どこまでを自社で運用し、どこからをMSPやSIerに任せるか」をセットで設計しておくことが、最終的なコスト満足度を大きく左右します。

ハードウェア選定のリアル!Azure LocalとDellやHPEやLenovoの構成パターンを徹底比較

オンプレ更新のたびに「どのサーバーを選ぶか」で会議が迷走していないでしょうか。ローカルクラウド基盤では、ここで外すと数年分の運用コストとトラブル確率が一気に跳ね上がります。基盤選定はカタログのスペック勝負ではなく、ユースケースと運用体制に合わせた“さじ加減”がポイントです。

Azure Localのハードウェア要件とカタログの読み解き方

この基盤の要件でまず押さえるべきは、次の3点です。

-

CPU: 物理コア数がライセンスと直結するため、クロックとコア数のバランスを見る

-

メモリ: 仮想デスクトップ(AVD)やSQL系が多い場合は1ノードあたり数百GBクラスを前提にする

-

ストレージ: S2D前提なので、キャッシュ用SSDと容量用SSD/HDDの比率が性能を大きく左右する

カタログでやりがちなミスは、「最大構成」に目を奪われてI/O要件を数字で詰めていないことです。AVDや業務サーバーのIOPS・スループットを概算し、ベンダーの実測ベンチ結果と照合しておくと、PoCで「思ったより遅い」という事態を防ぎやすくなります。

DellやHPEやLenovoに多い構成TierとVxRailや他HCIとの違い

各ベンダーは多くの場合、「Small / Medium / Large」のようなTierを用意しています。よくある整理イメージを示します。

| ベンダー | Small層の狙い | Medium層の狙い | Large層の狙い | VxRail等との違いのポイント |

|---|---|---|---|---|

| Dell | 支店・店舗向け2~3ノード | 本社/中規模DC向け | 大規模仮想基盤 | VxRailよりもAzure連携を前面に出した設計 |

| HPE | ROBO向け省スペース | 汎用業務サーバー群 | 高密度・高信頼 | 専用アプライアンス感より柔軟なカスタマイズ性 |

| Lenovo | 価格重視のエントリ | バランス型HCI | GPU搭載など拡張型 | SAPやVDIなど特化構成を組みやすい傾向 |

VxRailなどのHCIアプライアンスは、「VMware前提で全部入り」という世界観なのに対し、このローカルクラウド基盤向け構成は、Azure ArcやAVD、バックアップサービスとの連携を前提にしたハイブリッド設計がしやすい点が違いです。私の視点で言いますと、VMware文化が強い現場ほど、管理ツールと運用フローの違いをPoCで一度“体感”してからTierを決めた方が安全です。

小規模2ノードから複数ノード構成まで現場でよく選ばれるパターン

実案件でよく落ち着くパターンを整理します。

| パターン | 構成例 | 主なユースケース | 注意ポイント |

|---|---|---|---|

| 2ノード小規模 | Dell/HPE/Lenovoのエントリモデル×2 | 支店・工場の業務サーバー、軽量AVD | クォーラム確保のためWitness設計を最初に決める |

| 3~4ノード中規模 | ミドルTier×3~4 | 本社基盤、AVD + 業務システム混在 | ストレージとネットワークの冗長構成を標準化 |

| 8ノード級 | Large Tier×8前後 | 全社仮想基盤、DR統合 | 将来のスケールアウトとライセンス増分を試算しておく |

ローカルAI用途や画像解析を入れたい製造業・小売では、GPU搭載ノードを1~2台だけ混ぜる構成も増えています。この場合、GPUノードだけ電力・冷却要件が突出するため、ラック単位で電源計画を引き直しておくと、後から空調の増設工事になるリスクを避けやすくなります。

ハードウェア選定を「DellかHPEかLenovoか」のブランド論争で終わらせず、ここまでの観点をチェックリスト化しておくと、情シスやインフラ担当が経営層と同じテーブルで冷静に比較検討できるようになります。

ユースケースで見るAzure Local!AVDやバックアップやローカルAIの現場シナリオ

「オンプレを捨てきれないけれど、クラウドだけにも寄せきれない」現場で、このローカル基盤は単なるHCIではなく“現場とクラウドをつなぐハブ”として効きます。この章では、実際にインフラ担当が悩むAVD、バックアップ、ローカルAIのシナリオに絞って解像度を上げていきます。

Azure LocalでAVDを動かすときの利点やネットワーク設計の落とし穴

このローカル基盤上でAVDを動かす最大のメリットは、ユーザーと仮想デスクトップの距離を縮めつつ、管理はクラウド側で一元化できる点です。特に拠点が分散した企業では、次のような効果が見込めます。

-

拠点内にVDIを置くため操作レスポンスが改善

-

ユーザープロファイルやポリシーはクラウド側で統合管理

-

回線障害時も業務継続しやすい設計が取りやすい

一方で、ネットワーク設計を甘く見ると痛い目を見ます。私の視点で言いますと、AVD連携でよく見かける“ハマりどころ”は次の3点です。

-

network gatewayの帯域と冗長構成を軽視し、ピーク時にゲートウェイがボトルネックになる

-

DNSと名前解決の設計が曖昧で、セッションホスト登録や更新に失敗する

-

QoSやトラフィック分離をしておらず、バックアップとAVDが同時間帯にぶつかり体感性能が急落する

対策としては、AVDトラフィックとバックアップ/レプリケーションを論理的に分離し、ピーク帯の帯域シミュレーションをPoC段階で行うことがポイントになります。

Azure BackupやSite Recoveryを組み合わせたバックアップやDRパターン

バックアップとDRは、「クラウドに全部投げれば安心」ではなく、どこまでをローカルで抱え、どこからをクラウドに逃がすかが勝負どころです。代表的なパターンを整理すると、次のようになります。

| パターン | 概要 | 向いているケース |

|---|---|---|

| ローカルスナップショット集中型 | S2D上のスナップショット中心、クラウドはメタデータ程度 | リストア頻度が高く、回線が細い拠点 |

| クラウドバックアップ併用型 | ローカル+Azure Backupで長期保管 | 法令で保存年数が長く求められる業種 |

| フルDRレプリケーション型 | Site Recoveryで別拠点やクラウドへレプリケーション | 災害時も短時間で復旧したい基幹系 |

ポイントは次の3つです。

-

RPO/RTOを業務単位で数値化してから方式を選ぶ

-

週次・月次のフルバックアップ時の回線使用率を事前に試算する

-

復旧テストを四半期ごとに実施し、手順の陳腐化を防ぐ

現場では、「バックアップは取れているが、復旧シナリオが具体的でない」ケースが多く、DRテストを実施した瞬間にスクリプトや権限周りの穴が露呈します。PoCの段階で、実際に1台VMを落としてクラウドから戻す演習をしておくことが、後々の保険になります。

工場や店舗でのローカルAIやエッジ活用とWasabiなど他ストレージとの棲み分け

工場や店舗のようなエッジ環境では、低遅延処理とデータ主権が大きなテーマになります。このローカル基盤をエッジAIの土台にする際、よくあるシナリオは次の通りです。

-

工場ラインでの画像認識AIをローカルで推論し、学習データだけをクラウドへ送る

-

店舗サーバーをHCIに統合し、在庫/映像/分析を1筐体で処理

-

公共系で、個人情報をローカルに保持しつつ分析結果のみクラウド連携

ここで効いてくるのが、クラウドストレージやWasabiのようなオブジェクトストレージとの棲み分けです。

| 役割 | ローカルHCI | クラウド/オブジェクトストレージ |

|---|---|---|

| 主な用途 | リアルタイム処理、VDI、AI推論 | アーカイブ、ログ保管、DR用コピー |

| 強み | 低遅延、高速I/O、データ主権 | 容量単価の安さ、耐久性、地理的冗長 |

| 弱み | 容量拡張の物理制約 | レイテンシ、回線依存 |

エッジAIでは、生データを全てクラウドに送ると回線コストが跳ね上がります。そのため、推論処理と一時保存をローカルに寄せ、学習用に間引いたデータや集計結果だけをオブジェクトストレージへ送る設計が現実的です。

このローカル基盤は、HCIとしての堅牢さに加えて、Azure ArcやAVD、Backupとの連携で“クラウドと会話できるオンプレ”を作れる点が強みです。AVD、バックアップ、ローカルAIをきちんと設計できれば、単なる更新案件から、次の10年を見据えたハイブリッド基盤プロジェクトへと格上げしやすくなります。

構築やインストールの教科書には載らない落とし穴と回避パターン

現場でよく見るのは、「カタログ通りに組んだはずなのに、パッチを当てた瞬間に止まる基盤」です。ここでは構築担当が本番前に必ず押さえておきたい“沼ポイント”を整理します。

Azure Localインストール前に必ず洗うべき要件チェックリスト

インストール前の要件洗い出しが甘いと、その後数年分の運用トラブルを前払いしてしまいます。私の視点で言いますと、以下を満たせていない案件は高確率で炎上します。

事前チェックの最小セット

-

ハードウェア対応: OEMカタログとサポートマトリクスで型番とNIC/SSDを1つずつ突き合わせる

-

ストレージ設計: S2D用のディスク本数とキャッシュ階層、書き込みパターンをワークロード単位で確認

-

ドメイン/名前解決: DNSサフィックス、NetBIOS名、UPNの整合性をActive Directory全体で棚卸し

-

時刻同期: 物理Server、ホストOS、ゲストOS、仮想ドメインコントローラの階層を図にして明文化

-

運用前提: パッチウィンドウ、再起動可能時間帯、バックアップ製品との整合を決裁者と握る

下の表を埋めながら要件定義書に落としておくと、後から「聞いていない」を減らせます。

| 項目 | 最低限の決めごと | ありがちな失敗例 |

|---|---|---|

| ホスト命名規則 | 拠点名+役割+連番 | PoCと本番で命名ルールがバラバラ |

| IPアドレス計画 | 管理系/クラスタ系/ストレージ系を分離 | 1つのセグメントに全部押し込む |

| バックアップ方式 | VM単位かボリューム単位かを明示 | S2Dの層を意識せずスナップを量産 |

| 監視範囲 | ホスト、VM、ゲストOSの責任分界点を明記 | ベンダーと情シスでお見合い状態 |

23H2アップグレードで実際に起きたトラブルとdisjoint namespaceの罠

23H2世代へのアップグレードでは、名前解決と証明書周りが地雷原になります。特にdisjoint namespace構成は要注意です。

典型的なトラブルパターン

-

ADドメイン名とDNSサフィックスが違う環境で、MOC関連サービスが起動しない

-

クラスタノードが自己署名証明書の名前不一致でWACから管理できなくなる

-

Arc登録済みのリソースがアップグレード後に「未接続」表示のまま復帰しない

発生しやすい条件を整理すると、設計段階での回避ポイントが見えてきます。

| 条件 | 症状 | 設計時の対策ポイント |

|---|---|---|

| disjoint namespace | MOCサービス起動失敗 | SPNとDNSサフィックスを事前に統一するか是正 |

| 古い証明書基盤 | 管理ポータルが証明書エラーで警告 | ルートCA/中間CAの有効期限とCNを棚卸し |

| 手動でArc登録したPoC環境 | 本番アップグレード後に重複登録 | PoC用サブスクリプションと本番を明確に分離 |

アップグレード前の検証では、「新規インストールで動くか」ではなく「既存のドメイン設計を引きずったまま動くか」に焦点を当てると、現場の事故をかなり減らせます。

network gatewayやDNS設計でつまずいたケーススタディとプロの対処法

ネットワーク設計は図面上はきれいでも、運用を始めると一気にボロが出ます。特にnetwork gatewayとDNSまわりは、VMwareやVxRailから移るときの感覚の違いでつまずきがちです。

よくあるつまずきケース

-

AVDを使う前提で帯域を見積もったが、gatewayとの往復で実効帯域が足りずログオン遅延

-

管理系とワークロード系が同一セグメントで、バックアップトラフィックが管理ポータルを圧迫

-

DNSフォワーダーの経路が複雑になり、Arc連携やBackupサービスだけ名前解決に失敗

対処のコツは「オンプレ発想」と「クラウド発想」のすり合わせを最初にやり切ることです。

-

network gatewayは、拠点ルータではなくクラウド側の延長として帯域とレイテンシを設計する

-

DNSは、オンプレのドメインコントローラを一次、クラウド側を二次とするか、その逆かを整理し経路を1パターンに絞る

-

バックアップと監視のトラフィックは、可能な限り専用VLANかQoSで隔離し、障害調査系の通信を守る

このあたりを設計書レベルで詰めておけば、構築後数年にわたって「原因不明の遅い」「たまに繋がらない」といったストレスを避けやすくなります。インストール手順書には書かれていない部分こそ、インフラ担当の腕の見せどころです。

VMwareやVxRailからAzure Localへ本当に移るべきか?冷静な比較軸でプロが解説

VMware更新やVxRail更改のタイミングで、なんとなくハイブリッド基盤に興味が出てきたものの、「本当に今、動くべきか」が腹落ちしていない方が多いです。ここでは感情論ではなく、現場で意思決定に使っている軸だけをシンプルに整理します。

VMwareとAzure Localの機能や運用やサポート比較で見えてくる向き不向き

仮想化基盤として見ると、どちらも「仮想マシンを安定稼働させる箱」です。違いが効いてくるのは、その先にある運用とクラウド連携です。

| 観点 | VMware vSphere系 | Azure Local系 |

|---|---|---|

| 中核機能 | vCenterでのVM管理 | Windows ServerとHyper-VとHCI OS |

| 運用の世界観 | データセンター完結 | Azure PortalとArcでハイブリッド管理 |

| 周辺サービス | サードパーティ製が豊富 | AVDやBackupやSite Recoveryと親和性高い |

| サポート窓口 | VMwareとハードベンダー | MicrosoftとOEMベンダー |

向いているケースは次のイメージです。

-

VMware向き

- 既存運用チームがvSphere前提で回っており、オンプレ完結が当面の方針

- ネットワーク分離やレガシーOSも含めた「現状維持」が最優先

-

Azure Local向き

- 将来的にAVDやクラウドバックアップ、AI推論などAzureサービスを積極活用したい

- ArcベースでサーバーもKubernetesも一元管理したい

私の視点で言いますと、「運用コンソールをどこに一本化したいか」を最初に決めると、迷いがかなり減ります。

VxRailや他HCIと比べてAzure Localが選ばれるケースと選ばれないケース

VxRailや他HCIは、「ハードウェアとソフトウェアがきっちり統合された家電」に近い存在です。一方でAzure Localは、「Azureに直結した拠点用ミニデータセンター」という設計思想があります。

| ポイント | VxRailや他HCIが強い | Azure Localが強い |

|---|---|---|

| 初期導入のわかりやすさ | アプライアンス前提の定型構成 | ベンダーにより幅がある |

| バージョン管理 | バンドルで一括検証済み | OSとAzure側の両方を意識 |

| ハイブリッド | 他社クラウドも含めて中立 | Azureサービスとの一体運用 |

Azure Localが選ばれやすいのは、次のようなシナリオです。

-

店舗や工場ごとに小規模クラスターを置き、クラウド側で一括運用したい

-

バックアップやDRをAzure BackupやSite Recoveryに寄せて、二次サイトを持たずに済ませたい

-

将来的にローカルAI推論やエッジ分析を展開したい

逆に次のような場合は、VxRailを含む他HCIの継続も選択肢になります。

-

既にvSANベースの設計を全社標準にしており、監視やバックアップもVMware前提

-

海外拠点を含めてマルチクラウド戦略で、Azure偏重を避けたい

移行シナリオ別に見る今は動かさない方がいいワークロードの見極め方

「全部乗り換える前提」で考えるとプロジェクトが破綻しやすくなります。移行シナリオごとに、「今は触らないほうが安全」な領域を明確に線引きしておくことが重要です。

移行検討時に、次のようなワークロードは慎重に扱う方が無難です。

-

ライセンスやサポートが物理サーバーや特定ハイパーバイザーに強く紐づいているパッケージ製品

-

リアルタイム制御を行う工場向けシステムで、レイテンシ要件を厳格に満たしている既存環境

-

数千台規模のVDIを単一VDI製品で動かしている環境で、認証やプロファイル管理を含めて密結合になっているケース

一方で、移行候補にしやすいのは次のタイプです。

-

ファイルサーバーや業務アプリサーバーなど、標準的なWindows Server環境

-

既にAzure ADやMicrosoft 365を使っていて、ID基盤がクラウド寄りになっている拠点

-

バックアップやDR構成を見直したいが、二次サイトの投資を抑えたいシステム

この切り分けを整理した上で、「どのクラスターから、どの単位で動かすか」を設計図レベルで描けるかどうかが、成功と失敗の分かれ目です。決してブランド名だけで判断せず、自社の運用と今後5年のクラウド戦略を軸に、冷静に比較してみてください。

失敗事例から逆算するAzure Local導入プロジェクトの進め方がポイント!

オンプレ刷新やVMware更新のタイミングで、このローカル基盤を「とりあえずPoCしてみますか」と軽く始めると、後半で財布もスケジュールも燃え尽きます。鍵になるのは、失敗事例から逆算してロードマップを設計することです。

PoCで検証しておかないと本番で痛むポイントとは

PoCは「動いたかどうか」ではなく、「運用して耐えられるかどうか」を見るフェーズです。現場で痛みがちなポイントを整理すると次のようになります。

| 検証観点 | よくある失敗 | PoCで必ず見るポイント |

|---|---|---|

| ストレージ(S2D) | VM数だけで評価しIOを無視 | 実ワークロードに近いIOパターンで負荷試験 |

| ネットワーク | network gatewayだけピン疎通で終わり | 帯域・遅延・フェイルオーバー動作 |

| ID・DNS・名前解決 | disjoint namespaceを放置 | ドメイン/PSO/証明書の動作確認 |

| 監視・バックアップ | クラウド側だけで完結と誤解 | ローカルとクラウド両方の障害シナリオ |

特にAVDや業務サーバーを乗せる場合は、クライアントからの体感レスポンスをPoCで必ず測るべきです。RDP遅延やプロファイル格納先の設計を甘く見ると、リプレース後に「VMは安定しているのにユーザー満足度は大暴落」という典型パターンにはまります。

アップグレードやパッチ適用を安全に回すための運用ルール作り

この基盤はWindows Serverと同じ感覚で「夜中にパッチを当てればいい」と扱うと痛みます。23H2アップグレードや累積更新で、MOC関連サービスが上がらない、クラスターが片側だけ古いバージョンで止まる、といった事例は珍しくありません。

運用ルールは最低でも次のレベルまで具体化しておきます。

-

バージョン戦略

- クラスタごとに「ターゲットバージョン」と「許容下限」を定義

- Azure Arcや管理ツールとの互換性マトリクスを事前に確認

-

パッチ適用プロセス

- ラボ環境か小規模クラスタでの事前検証を必須化

- 1ノードずつドレイン→適用→ヘルスチェック→復帰を標準手順にする

- S2Dのリバランス完了を確認してから次ノードへ進む

-

ロールバック設計

- 失敗時の復旧時間目標(RTO)と手順を文書化

- Azure BackupやSite Recoveryで、構成情報レベルまで巻き戻せるかを確認

私の視点で言いますと、ここを「運用チーム任せ」にして設計段階で議論しないプロジェクトは、高確率で2回目以降のアップグレードで止まります。

ベンダー選定時にチェックすべきHCI経験とAzure理解のバランス

ハードウェアがDellでもHPEでもLenovoでも、失敗するプロジェクトの多くはベンダーの得意・不得意を見誤っているケースです。チェックすべきは価格よりスキルバランスです。

| 観点 | HCI寄りベンダーが強い点 | Azure寄りベンダーが強い点 | 足りないと起きる問題 |

|---|---|---|---|

| クラスタ/ストレージ | S2Dチューニング、NIC設計 | – | 性能出ない・障害切り分けが長期化 |

| クラウド連携 | – | Azure Arc、AVD、Backup設計 | バックアップ費用膨張、ライセンス過剰 |

| 運用設計 | HCIライフサイクル管理 | Azureポリシー、RBAC | 権限設計崩壊、監査でNG |

| トラブル対応 | ハード・ドライバ・ファーム | サブスクリプション/ポータル | エスカレーションが分断される |

提案依頼時には、次のような質問を投げるとスキル差がはっきり出ます。

-

23H2アップグレードでの既知のハマりどころと回避策を具体例付きで説明できるか

-

VMwareやVxRailからの移行で「今は動かさない方がいい」ワークロードをどう判断しているか

-

AVDやバックアップ料金を含めた5年総コスト試算のサンプルを持っているか

このあたりに即答できるベンダーは、単に仮想マシンが動く箱ではなく、「ハイブリッド基盤としてのライフサイクル」を理解しています。導入後の数年間を安全に走り切れるかどうかは、ここでほぼ決まると言っても大げさではありません。

Azure Localを扱うSIerやMSPが集客で差をつけるためのコンテンツ設計術

オンプレ刷新やVMware更新のタイミングで、検討担当者はベンダーの営業トークよりも「検索で拾える具体情報」を信用します。ここを押さえたSIerやMSPだけが、見積前の早い段階から“指名で相談される立場”になれます。

Azure Localの検索ユーザーが知りたがっている5つのコンテンツとは

私の視点で言いますと、案件化しやすい問い合わせはほぼ次の5種類のコンテンツを経由しています。

-

全体像と位置づけ解説

・Azure Stack HCIとの違い

・VMwareやVxRailとのざっくり比較 -

価格とライセンスの考え方

・物理コア課金とサブスクリプションの整理

・AVDやバックアップのランニング費用感 -

ハードウェア構成例と要件

・DellやHPEやLenovoのモデル別パターン

・2ノードから複数ノードまでの目安 -

ユースケースと構成図付きの解説

・AVD、バックアップ、DR、ローカルAIの構成例

・network gateway設計時の制約と遅延の目安 -

トラブル事例と設計チェックリスト

・23H2アップグレード、S2D、disjoint namespaceのハマりどころ

・運用設計テンプレート

この5つを揃えることで、「概要だけ読んで別サイトで価格」「別サイトでトラブル調査」という“離脱のはしご”を断ち切れます。

価格ページや比較記事や技術ブログをどう組み合わせると相談が増えるか

単発の技術ブログを量産しても、問い合わせフォームにたどり着かない構造では成果が出ません。ポイントは導線と役割分担です。

| コンテンツ種別 | 役割 | 置くべきCTA |

|---|---|---|

| 価格の考え方ページ | 経営層・情シス責任者向けに投資対効果を整理 | 概算見積りダウンロード、相談フォーム |

| 比較記事(VMware / VxRail) | インフラ担当の「本当に替えるべきか?」に回答 | PoC相談、アセスメント診断 |

| 技術ブログ | エンジニアの不安(構築・運用・トラブル)を解消 | 詳細設計支援、構成レビューサービス |

| 導入ステップ解説 | プロジェクト全体像を見せて心理的ハードルを下げる | プロジェクト相談会、ウェビナー案内 |

価格ページでは「この規模なら物理コアが何個で、概算月額はこのレンジ」という数字感と同時に、バックアップやAVDの隠れコストもテーブルで示すと、経営層の“後出しNG”警戒心が和らぎます。

技術ブログは、network gatewayやDNS設計の失敗例、S2Dの再同期でバックアップ窓が潰れた事例など、現場で本当に起きたパターンを1テーマ1記事で深掘りします。そこから「構成レビュー無料」のような軽いCTAへつなげると、エンジニア主導の相談が自然に増えていきます。

8万サイト超のWeb制作支援から見えたBtoBインフラサービスの勝ちパターン

BtoBインフラ領域で安定してリードを獲得している企業には、共通する“型”があります。

-

技術解説だけで終わらせない

・AVDやバックアップの記事の最後に、「この規模・用途ならどの構成が妥当か」を3パターン程度に整理し、判断材料を与えている

-

検索意図別にページを分ける

・価格

・比較(VMware、VxRail、他HCI)

・構築・運用のTips

を意図ごとに独立させ、内部リンクでストーリー化 -

“失敗と対策”をあえて前面に出す

・23H2アップグレード時のMOCサービス不調

・disjoint namespaceでクラスタ登録に失敗した事例

・network gateway越しのAVDで遅延が許容値を超えたケース

などを匿名のケーススタディとして整理し、「設計段階でどう潰すか」を提示 -

フォームにたどり着く前に不安を8割潰す

・よくある質問として、「VMwareからどこまで段階的に移行できるか」「既存バックアップ製品との同居可否」を具体記載

この型を踏まえ、Azure Localを単なる仮想化基盤ではなく、「既存オンプレの痛みをどう減らすか」という物語で語れるSIerやMSPほど、価格競争から抜け出して指名相談を獲得しやすくなります。検索で見つけた時点で“この会社は現場を分かっている”と感じてもらえるかどうかが、集客の分水嶺になります。

この記事を書いた理由

著者 – 宇井 和朗(株式会社アシスト 代表)

Azure Localのようなインフラ系テーマを、ここまで踏み込んで言語化したのは、インフラ刷新とWeb集客の両方が中途半端なまま走り出し、数年単位で苦しんでいる企業を何度も見てきたからです。

VMwareやVxRailの更新タイミングで「ベンダーに勧められたからAzure Stack HCIに」「名前が変わっただけだと聞いたのでAzure Localに」と決めてしまい、物理コア課金やバックアップ、AVDのコスト、DNSやnetwork gatewayの設計を詰め切らないまま進めた結果、障害対応と運用費が膨らんだケースは珍しくありません。

同時に、BtoBインフラサービスのサイトを多数支援する中で、「Azure Local対応」「VMware代替」といった単語だけを並べたページでは、問い合わせは増えても案件化しない、というパターンも繰り返し見てきました。経営層が判断に使える価格とライセンスの整理、現場担当がそのままPoCや構成検討に使える具体像、この両方がそろって初めて本当の意味での集客と成約につながります。

この記事では、私自身が経営者としてインフラ投資の意思決定をしてきた視点と、多数の企業サイトを見てきた視点を重ね、Azure Localを「売る側」と「導入する側」のどちらにとっても、誤解と手戻りを最小限にできる判断材料を提供することを目的としています。